Überspitzt gesagt, bin ich der Meinung, dass man sich an der Börse entweder sehr detailliert mit den fundamentalen Kennzahlen einzelner Unternehmen auseinandersetzen soll oder lieber gar nicht (so sehr) auf Kennzahlen achten (sondern ganz andere Faktoren wie zum Beispiel Branchen- und Technologietrends oder makrowirtschaftliche Verschiebungen wie Inflation, Deflation, Globalisierung, Lohnentwicklung etc. betrachten).

Auf jeden Fall sollte man nicht halbe Sachen machen und sich auf vereinfachte Metriken verlassen (zudem noch auf solche, die eine große Anzahl von Unternehmen per Durchschnittsbildung erfassen).

Eine solche vereinfachte Metrik ist das KGV (vgl. die KGV-Masche).

Ich will nicht grundsätzlich das Konzept des KGV angreifen. Es macht schon Sinn, die Gewinne der Unternehmen in Relation zu deren Aktienkursen zu setzen. Es ist auf jeden Fall eine nützliche Orientierungshilfe. Nur ist es leider so, dass das KGV selten eine gute Orientierungshilfe darstellt, wenn es um Market Timing geht.

Ich selbst schaue auch mal gern nach dem KGV (und anderen ähnlichen Kennziffern) und höre mir Überlegungen zu den Gewinn-, Umsatz- und Buchwert-Relationen an, aber ich bin selten geneigt, daraus konkrete Argumente für die Entwicklung der Börsen zu akzeptieren.

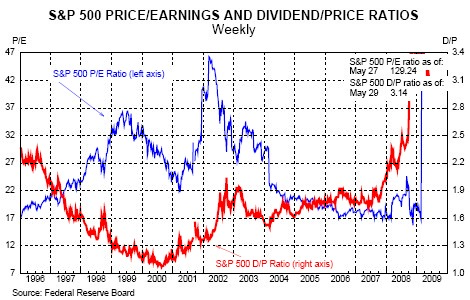

Denn, betrachtet man den KGV-Chart für den amerikanischen Markt oben (S&P 500, blaue Linie = KGV, gemeldete Gewinne; rote Linie = Dividendenrendite) , stellt man irritiert fest:

- Anfang 1998 war der Markt genauso hoch oder niedrig bewertet wie Anfang 2001. Und doch waren das zwei völlig unterschiedliche Zeitpunkte: der erste — eine herausragende Einstiegmöglichkeit, der zweite — noch 2 Jahre vor dem Ende einer tiefen Baisse.

- Die Zeit der Trendumkehr nach der 2000er Baisse, also ab Mitte 2002 bis Mitte 2003, tut sich auch nicht mit niedriger Bewertung hervor. Ganz im Gegenteil — die KGVs waren gerade hier besonders hoch (und wieder dieses Paradoxon: Die Wende kam fast bei dem gleichen KGV-Stand wie zum Hochpunkt der Euphorie 2000).

- Schließlich ermittelte man ein ziemlich konstantes und relativ niedriges KGV zwischen 2005 und 2007, aber dies konnte in keinster Weise verhindern, dass der S&P 500 2008 so ungefähr 50% seines Wertes verloren hat.

Daher kann ich Aussagen wie “Aktien sind teuer wie nie zuvor” (Handelsblatt), die sich explizit (und nur) auf das KGV beziehen, nicht als sehr zuverlässig, fast nicht als seriöse betrachten.

Das Kurs-Gewinn-Verhältnis der größten amerikanischen Aktien ist — siehe oben — wahrlich explodiert, aber dies ist vor allem ein gigantischer rechnerischer Effekt… Für Market Timing dürfte es genauso ungeeignet sein wie in der Vergangenheit.

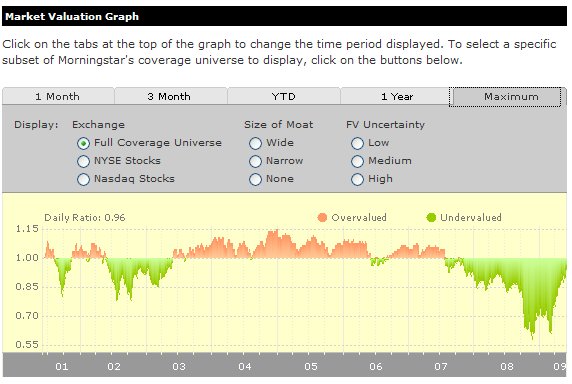

Es gibt auch Konzepte, die eine Stufe differenzierter sind, und die Bewertungskennzahlen wie das KGV wiederum in Relation mit anderen Größen, meistens mit dem langfristigen Zinsniveau, kombinieren. Ein bekannter Indikator ist der Morning Star Market Valuation Graph. Eine feine Sache, aber leider auch ziemlich neben dem tatsächlichen Börsenverlauf. Trotzdem… es wird etwas besser…

Quelle (screenshot): Morning Star, Valuation Graph

Man soll sich dabei eher auf die Tendenzen und die extremen Ausschläge konzentrieren. Interessant wieder: 2003, genauso wie jetzt, verschlechterte sich die Bewertung schnell just vor der Börsenwende und auch danach. Nach den gängigen Kriterien wären die Aktien zu teuer. Vielleicht waren sie auch, aber die Börse hatte kein Problem damit.

Mit einem Wort: Aus einfachen Aktienbewertungen auf die zukünftige Entwicklung der Börse zu schließen, ist äußerst unzuverlässig. Man soll solchen Aussagen kaum Glauben schenken.

4 Kommentare bis jetzt ↓

Holger // 4. Jun, 2009

… und aus komplizierteren Bewertungsmethoden auf die Zukunft der Börse zu schließen, klappt auch nicht wirklich. Dieser Blick aufs KGV bezogen auf ein Jahr ist aber immer besonders lustig. Ist ja klar, dass die Gewinne in der Rezession sinken und damit auch das KGV tendenziell wieder steigt. Mich würde die gleiche Grafik mal mit Zehn-Jahres-Durchschnitts-KGVs interessieren…

Dieser Blick aufs KGV bezogen auf ein Jahr ist aber immer besonders lustig. Ist ja klar, dass die Gewinne in der Rezession sinken und damit auch das KGV tendenziell wieder steigt. Mich würde die gleiche Grafik mal mit Zehn-Jahres-Durchschnitts-KGVs interessieren…

Saviano // 4. Jun, 2009

Google ist schon goldig: KGV10 Grafik, Mai 2009. Laut Autor startet eine neue Hausse erst von Niveaus von ca. 10. Im März sollen wir 14 erreicht haben. Der S&P 500 Chart, der da eingezeichnet ist, ist inflationsbereinigt. Dies zur Info.

***

Nachtrag: Es gibt offensichtlich auch andere Schätzungen (s. hierzu auch Punkt 1 unten) — im März errechnet StarCapital (PDF) ein KGV10 in Deutschland von 9,7, in den USA von 12,8, für die Welt von 11,7.

Nachtrag 2: Noch krasser ist für mich das KUV (Kurs-Umsatz-Verhältnis, im PDF oben: PS – Price/Sales) — In Deutschland kauft man den Markt für den Umsatz von 5 Monaten (PS=0,4), in den USA für nicht einmal von 1 Jahr (PS=0,8), die Welt “kostet” den Umsatz für gute 8 Monate (PS=0,7). Das ist niedrig!

***

Ich befürchte jedoch, dass wir es hier mit einigen statistischen Effekten zu tun haben, die die Betrachtung nicht leicht machen (ich sage ja: nicht einfache Metriken verwenden!):

1. Der Index dort ist inflationsbereinigt — warum? Wir wissen auch nicht, ob die Gewinne ebenfalls inflationsbereinigt sind, und ob inflationsbereinigt mit nicht-bereinigt in Relation gesetzt wurde. Das kann man freilich nachrecherchieren bzw. nachberechnen, erschwert hier das “Chart-Lesen”.

2. Was die Methode betrifft: Bildet man einen gleitenden Durchschnitt, glättet man — logischerweise — die Ergebnisse. Jedoch — nimmt man zu viele Werte, werden wir automatisch einen fast konstanten Nenner erhalten, so dass die Schwankungen ausschließlich von der Kursentwicklung resultieren. Daher ist es kein Wunder, dass die beiden Grafiken so synchron verlaufen. Eine wirkliche Erklärung (geschweige denn Kausalität) ist das nicht. Es wird lediglich gezeigt, dass die Aktien in einer längeren Periode scheinbar um einen Mittelwert (-range) schwanken. Das ist auch sonst logisch (common sense).

Würde man die KGV20-Grafik bilden, würden wir noch “exakter” den Kursverlauf tracken (bei der richtigen Skalierung, versteht sich).

3. Schließlich: So betrachtet, müsste man ungefähr 1985 aus den Aktien aussteigen und nie wieder einsteigen. Das kann doch nicht “richtig” sein.

Die Statistik-Kenner korrigieren und ergänzen mich bitte. Ich denke, es lassen sich auch ein paar andere Problemchen finden…

investor78 // 21. Dez, 2009

Hier wird wirklich der Finger in die richtige Wunde gelegt. Den KGV unterschiedslos auf alle Unternehmen – egal in welcher Marktsituation – anzuwenden hat mit fundamental Analyse nichts zu tun.

Aber seltsamerweise funktionieren die Börsen teilweise so. Jeder der DCF-Bewertung kennt, weiss, das bei stabilen Zukunftsaussichten ein zyklisch sinkender Gewinn durch ein steigendes Multiple ausgeglichen werden.

In Wirklichkeit passiert aber das Gegenteil. Anleger und Börsenzeitschriften erwarten niedrigere KGVs!

Was muss man also machen?

M.E. nach eine Kombination an Instrumentarien einsetzen.

1. Die strategische Position des Unternehmens identifizieren (Konkurrenz, zyklisch/nichtzyklisch, technologieabhängig, aktuelle Risiken und strukturelle Veränderungen (z.B. Q-Cells))

1b. Schätzen wichtiger externer Faktoren wie z.B. Rohstoffpreise

2. Darauf aufbauend und mit Rückblick auf frühere Gewinnniveus und langfristiges Branchenwachstum “normalisiertes Gewinnniveau” bestimmen

(sehr gut möglich für z.B. Chemieunternehmen)

3. KGV oder EV/EBITDA passend dazu berechnen. Eventuell in Bezug zu erwartetem langfristigem Wachstum setzen

4. Insolvenzrisiko einschätzen. Einschätzen, inwieweit Unternehmen sich eventuell unabhängig von Fundamentaldaten entwickelt (Aussortieren von intransparenten Branchen wie Beteiligungsgesellschaften/Immobilien, Nebenwerte)

5. Passendes Instrument wählen

Noch eine Anmerkung zu dem Vorgängerkommentar. Genau: Man muss den Durchschnitt der Gewinne, also des Nenners, am besten über einen Zyklus nehmen.

Was ich auch immer faszinierend finde, ist wie Analysten selbst bei Benutzung der angeblich objektiven DCF-Methode es immer wieder schaffen den aktuellen Aktienkurs zu treffen/rechtfertigen.

Bei Internetaktien klar. Aber bei Old Economy-Werten?

Aktuelles Beispiel: Aixtron und JP Morgan Analyst

Was man natürlich nicht vergessen darf: Vor ein paar Monater gab es einen riesigen Doomsday-Abschlag. In anderen Worten. Für jedes Unternehmen wurde je nach Zyklizität eine mehr oder weniger großes Insolvenzrisiko eingepreist.

Saviano // 21. Dez, 2009

Vielen Dank für den Kommentar. Ohne auf Einzelheiten einzugehen, will ich zustimmen, dass die Bewertung einzelner Aktien eben durch eine umfassende Analyse der langfristigen Entwicklung und Perspektiven erfolgen soll. Dabei darf (wird) man sich auf Kennzahlen stützen. Aber, wie ich im Beitrag geschrieben habe, ist eine solche Analyse — erstens — nur für einzelne Werte machbar, und — zweitens — kann man sie nicht auf eine oder nur wenige Bewertungsmetriken aufbauen.

Für den Gesamtmarkt wird man — falls überhaupt sinnvoll! — auf andere Methoden zurückgreifen müssen. (“Falls überhaupt sinnvoll” deswegen, weil große Investoren — ein ganz prominenter darunter ist Warren Buffett — sich nie für den Gesamtmarkt interessieren, sondern nur für konkrete Unternehmen. Ich, allerdings, versuche zunächst die große Markttendenz festzustellen).

Kommentieren: